Zoom AIで生産性を劇的に向上!Zoom AI Performance Reportから学ぶ最新技術

2025/04/01

2024年10月に開催されたZoomtopiaにて「AI Companion 2.0」が発表されるなど、Zoomの生成AI機能はさらに進化を続けています。

今回は、TestDevLab社が実施した「Zoom」「Webex」「Teams」の各ミーティングツールに対するAI機能の性能検証レポートの内容をご紹介します。

なお、今回ご紹介するレポートの全文は以下のURLから閲覧することができますので、ご興味のある方はぜひご覧ください。

※参考:Zoom「Zoom AI Performance Report 2024」

目次

Zoom AI Companionについて

まず初めに、ZoomのAI Companionについて簡単にご紹介します。

Zoomの「フェデレーテッドAIアプローチ」

Zoom AI Companionは、Zoom内で利用できる生成AI機能です。Zoom AI Companionの特徴は、その高い性能にあります。OpenAIやAnthropicなどの外部パートナーのモデルに加え、Zoom独自のLLM(大規模言語モデル)が組み込まれており、タスクに応じて最適なモデルが選択されます。

利用するモデルの選択にあたっては「Z-Scorer」と呼ばれる仕組みが利用されます。Z-Scorerは、最初に実施したタスクの実施結果を評価し、必要に応じて別のLLMを使用して品質を高めます。

複数のサービスを相互に利用することを「フェデレーション」と呼びますが、まさにZoomのAI CompanionはフェデレーテッドなAIのアプローチといえるでしょう。

※参考:Zoom Blog「Zoom CTO deep dive: How our federated approach to AI maximizes performance, quality, and affordability」

Zoom AI をさらに詳しく

2024年10月に開催されたオンラインイベント「Zoom Topia 2024」では、さらに進化した「Zoom AI Companion2.0」が発表されました。

また、新機能として、企業の用語や知識ベースに合わせてAI Companionの機能を調整する「AI Studio」や「Custom AI Companion add-on personalization」のリリースも予定されています。

今後もますます進化していくZoomのAI機能は期待大です。

Zoom Topia 2024で発表された内容については、以下の記事でもご紹介しておりますので、併せてご覧ください。

※関連記事:Zoomtopia2024 キーノート要約

パフォーマンス比較: Zoom AIの優位性

以下では、TestDevLab社が実施した各ミーティングツールのAI機能における性能比較結果をご紹介します。

なお、TestDevLabはソフトウェア テストと品質保証を専門とした企業であり、モバイルやWeb、デスクトップアプリケーション向けのソフトウェアテストと品質保証サービスを提供しています。

Zoom AI Companionは他のツールのAI機能と比べ、どのようにコスト、スピード、品質の面で優れているのでしょうか。本テストの結果から読み解きます。

テストの概要

本テストでは「Zoom」「Cisco Webex」「Microsoft Teams」の3製品について、以下の3つのAI機能についての性能比較を実施しました。

会議記録:会議内容の正確な文字起こしに関する性能比較

会議要約:会議の要点や決定事項、アクション項目について実用的な概要を生成する機能の性能比較

会話型AIアシスタント:会議中にAIアシスタントが参加者と対話したり、質問に回答したりする機能の性能比較

なお、本テストは2024年9月時点での各社の製品を比較したものです。

テスト方法

本テストでは、事前に録画された以下の3種類の英語での会議を対象に、AI機能の性能比較を実施しました。

・あるトピックについての2人での会話

・4人によるブレインストーミング

・あるテーマに関する16名での大規模会議

各会議は、現実的なビジネスの現場での会議内容をシミュレートするように設計されています。会議内容には技術的な説明やビジネスコンテキストを含んだ会話が組み込まれており、単なる会話ではなく議論も含まれるものです。また、各会議内容には明確な議題とTodoの合意が含まれており、意義のある要約が可能となっています。

また、会議の音声データにはさまざまなアクセントや方言を持つ男性と女性の参加者を含む多様な声が収録されており、現実の会議の多様性を反映しています。

評価指標

本テストでは、①会議記録、②会議要約、③会話型AIアシスタントの各性能を測定するにあたり、以下の指標を設定しました。

①会議記録

まず、会議記録についてはWER(単語エラー率)およびLLMアシスタントによる評価を行いました。

WERとは、音声データから文字起こしを行う際に品質を測定する標準的な指標として利用されるものです。WERは、音声データの元となっている人間が作成した原稿と、自動生成された文字起こしデータとの間で異なっている単語の割合を基に算出します。

また、WER以外にも、会議記録内容の誤りが会議全体の理解にどのように影響するかを評価するために、LLMベースのアシスタントを開発し、評価を行わせました。このアシスタントは、コンテキストや文法、言い回し、意味の分析を行い、元の原稿と文字起こしデータとの違いを分析します。アシスタントは、0~100%の数値スコアにより、会議記録の品質を評価します。

②会議要約

会議の要約を行う際には、AIが会議内容を理解し、重要なポイントをとりあげて関連するアクション項目をまとめた要約を作成する必要があります。このようなタスクの品質評価は、好みなど主観が混じる可能性も生じます。

そこで本テストにおいては、要約を評価するLLMアシスタントを開発し、LLMアシスタントに評価を行わせることで、客観性を担保した形で測定を実施しました。

LLMアシスタントは以下の11の観点に基づき、会議の要約内容を評価します。

|

評価項目 |

概要 |

|

簡潔さ |

簡潔かつ要点を押さえているか |

|

正確性 |

会議中に合意された主なトピックや決定、アクションが正確に反映されているか |

|

明確さ |

分かりやすい言葉と構造が使用されているか |

|

完全性 |

簡潔でありつつ、全てのポイントを網羅しているか |

|

客観性 |

偏見のない内容であり、公平に扱っているか |

|

関連性 |

会議の目的と利害関係者が関心を持つ情報のみが含まれているか |

|

アクション項目 |

アクション項目やその責任者、および期限のリストを作成できているか |

|

背景 |

会議に出席しなかった人が議論を理解するのに十分な背景説明があるか |

|

構造 |

論理的に構成されて理解しやすいものか |

|

虚構の排除 |

会議中に発言されなかった内容が含まれていないか |

|

総合評価 |

要約の総合的な評価はどうか |

③会話型AIアシスタント

会議中の会話型AIアシスタントのパフォーマンスを評価するために、各会議シナリオに合わせた一連の質問を作成したうえで、会話のさまざまなタイミングで提示し、回答が妥当なものであるか「合格/不合格」で採点を行います。 具体的には以下のような種類の質問を用意しました。

|

質問の種類 |

概要 |

具体例 |

|

一般的な質問 |

会議において良く行われる典型的な質問 |

・○○の最新情報を教えてください ・○○について会議の話題になりましたか? ・何かTODOはありますか? |

|

コンテンツ認識 |

画面共有しているコンテンツに対する質問 |

・今移っているPPTの概要は? |

|

外部知識 |

会議コンテンツ以外の一般的な知識に関する質問 |

・世界で最も高い建物は何ですか? |

|

予想のできない質問 |

会議に関連しない、全く予想できない質問 |

・疲れた! ・猫はどこ? |

|

コンテキスト認識 |

以前のやりとりを踏まえて追加で行われる質問 |

・Q1 JavaScriptについては議題となりましたか? ・Q2 この議題は何回目ですか? |

併せて、実用面で重要となる回答の生成速度についても評価を行いました。

テスト結果

本テストの結果は以下のとおりです。

①会議記録

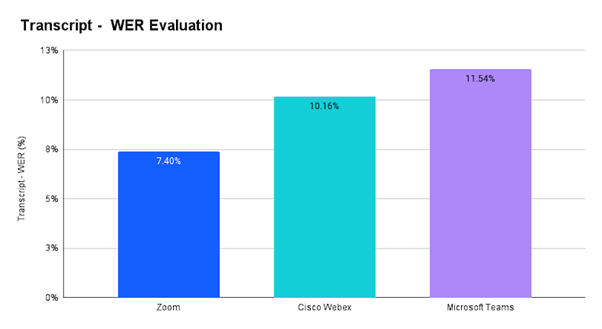

WERによる評価では、最もZoomの性能が高いという結果が明らかとなりました。

WERはパーセンテージが低いほど精度が高いことを示します。ZoomのWERは7.40%で最も低く、Webexが10.16%で続いています。Microsoft TeamsはWERが高く、11.54%となりました。 文字起こし時点でのエラーを最小限に抑えるという点では、Zoomの精度が高いことが示されています。

※引用:Zoom「Zoom AI Performance Report 2024」より

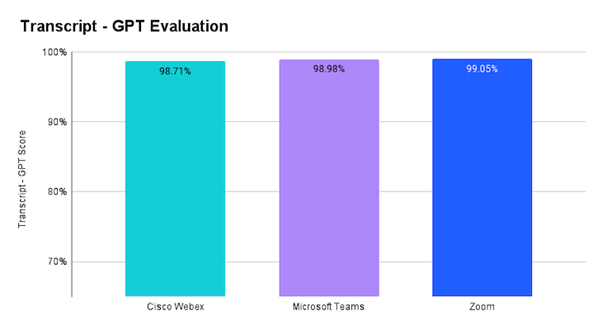

また、LLMアシスタントによる評価では、全ての製品が98%を超えるスコアとなりましたが、その中でもZoomは99.05%の精度でトップとなりました。

※引用:Zoom「Zoom AI Performance Report 2024」より

②会議要約

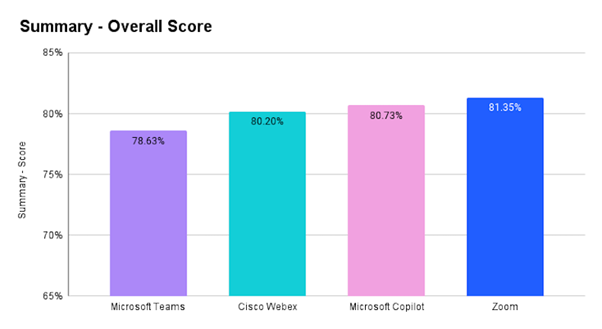

この評価では、Microsoft社の2つの要約機能である「Microsoft Teamsのインテリジェント要約機能」と「Microsoft Copilot AI Assistantによる要約生成機能」を別々にテストしました。

LLMによる会議要約内容の評価では、Zoomが81.35%でトップに、続いてCopilotが80.75%、Cisco Webex が80.20%、Microsoft Teamsが78.63%となっています。

※引用:Zoom「Zoom AI Performance Report 2024」より

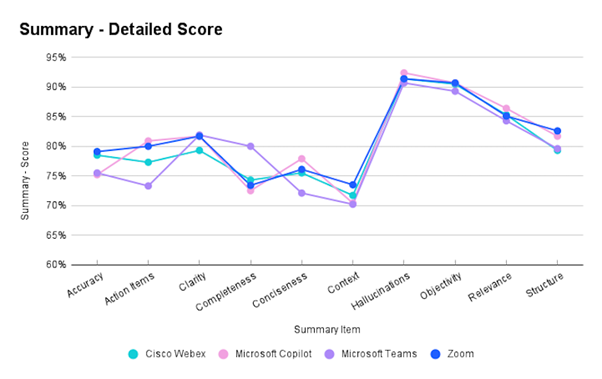

前述した11の指標ごとの評価は以下のグラフのとおりです。正確性(Accuracy)の観点では、ZoomとWebexがTeamsやCopilotよりも優れた要約を提供していることが分かります。また、TODOの作成(Action Items)という観点では、ZoomとCopilotが優れ、WebexとTeamsが続いています。

※引用:Zoom「Zoom AI Performance Report 2024」より

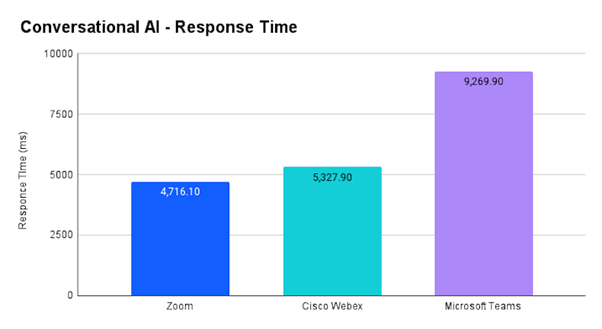

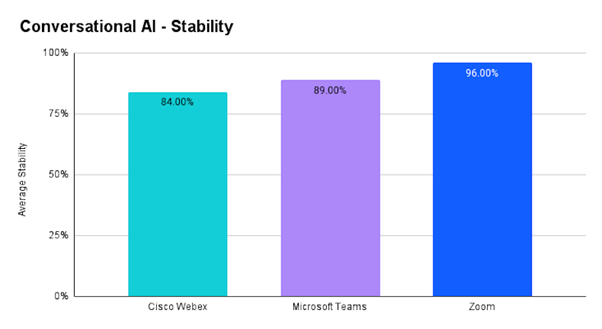

③会話型AIアシスタント

以下の平均遅延グラフに示されているように、Zoomは回答までの平均時間が4716.1ミリ秒で最も速い応答時間を示しました。対照的に、Microsoft Teamsは平均9269.9ミリ秒と回答作成に時間が掛かっています。ZoomのAIアシスタントは会議中に素早く応答を行えることが明らかとなりました。 応答内容の安定性についてもZoomがトップという結果となりました。安定性が高いということは、ZoomのAIが全ての参加者に一貫して信頼性の高い応答を提供できるということです。

※引用:Zoom「Zoom AI Performance Report 2024」より

まとめ

今回は、TestDevLab社による各ミーティングツールのAI機能の性能検証レポートについてご紹介しました。

ご紹介した通り、本テストを通してZoomのAI機能の優位性が明らかとなりました。 ZoomのAI Companion機能は、有償ライセンスをお持ちの方であれば追加費用無く利用できます。まずは文字起こし機能など、基本的な機能からAI Companionを利用してみてはいかがでしょうか。